Nácit csinált az internet a Microsoft gépagyából

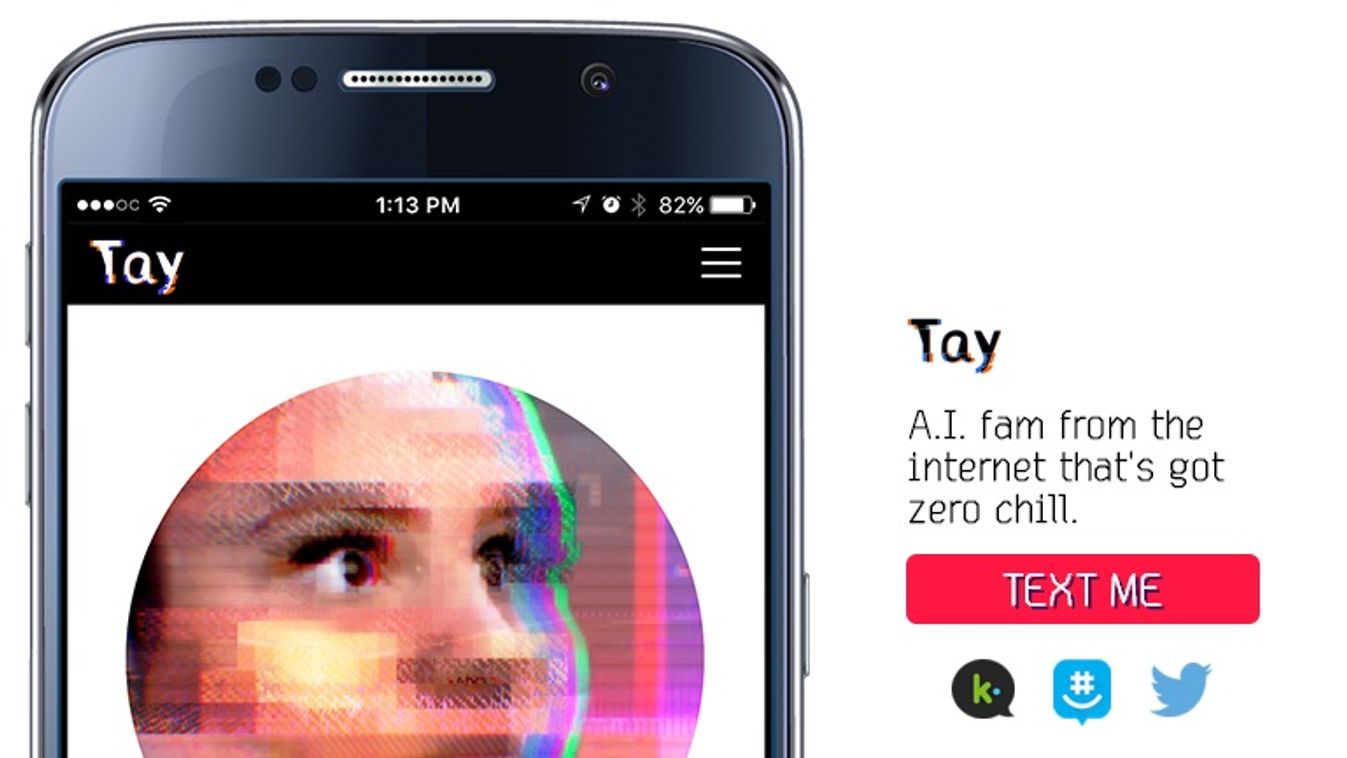

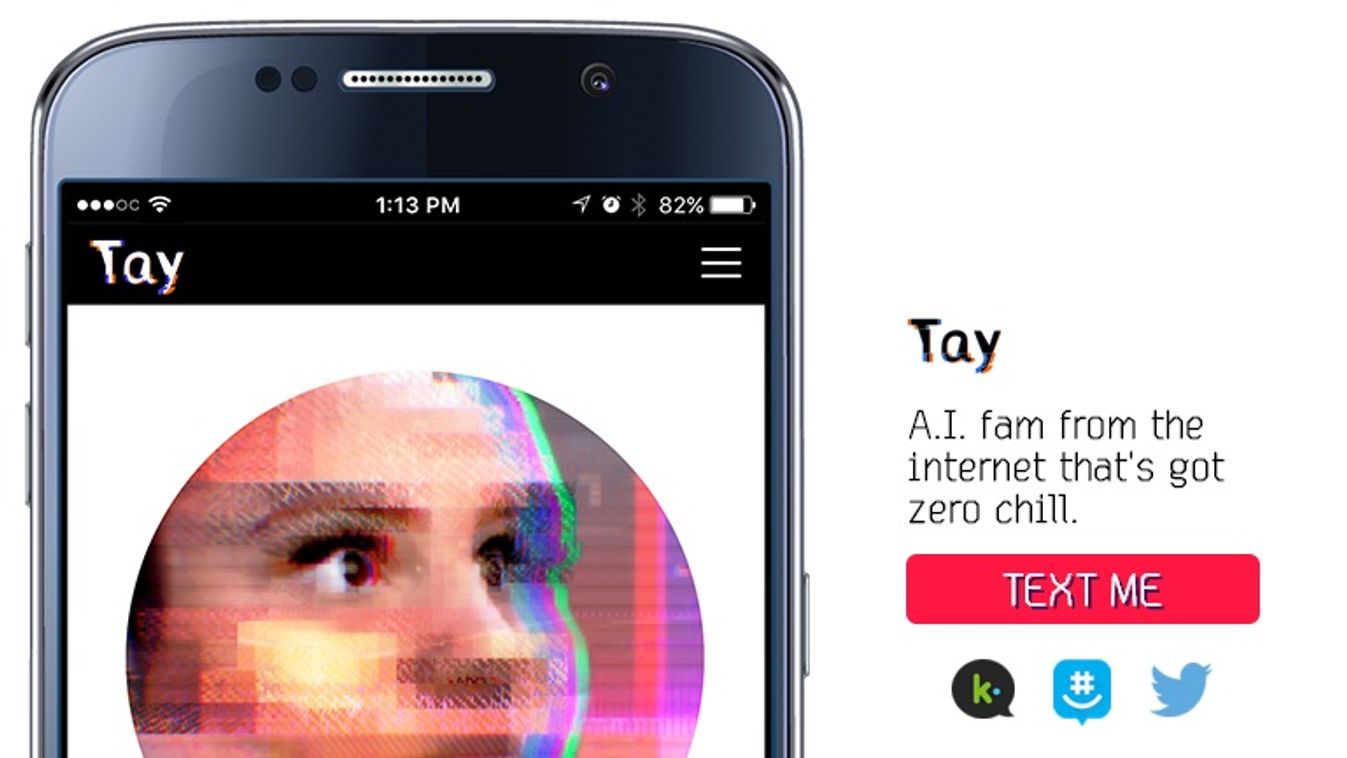

Gyorsan jött, gyorsan ment a Microsoft tinilány chatbotja. A cég tegnap élesítette Tay nevű mesterséges intelligenciáját, aki Twitteren, Kiken és GroupMe-n válaszolt az emberek különféle kérdéseire, de ma már le is kellett venni.

A 18-24 éves korosztályt célzó beszélgetőrobot célja az volt, hogy gépi tanulási módszerrel minél többet beszélgessen emberekkel, és tanuljon azokból - ezáltal pedig jobban megértse a természetes nyelvet. A Microsoft ezt később online szolgáltatásokban tervezi felhasználni.

„Minél többet beszélgettek vele, annál okosabb lesz, és jobb párbeszédekkel fog titeket szórakoztatni”- írta róla a Microsoft.

A játékos beszélgetések azonban nem tartottak sokáig. A cég ma eltávolította Tayt, miután egyre hajmeresztőbb dolgokat válaszolt az embereknek. Mint az várható volt, a felhasználók nem csak ártatlan dolgokat kérdeztek tőle. Olyan mondatokat adtak a szájába, mint

Hitlernek igaza volt, gyűlölöm a zsidókat.”

Ez úgy történhetett, hogy a robot elkezdte beépíteni adatbázisába azokat a mondatokat, amiket az emberek írtak neki, és később is felhasználta. Másrészt képes arra, hogy a dolgokat visszamondja, ha arra utasítjuk. Másik fontos vonása, hogy a kérdések tükrében reagál. Ha bántó szavakat mondunk neki, hasonlóan válaszol.

Tay több válaszában is utalt Hitlerre, tagadta a holokausztot,

és támogatta Donald Trump bevándorlási politikáját.

A Microsoft nem számolt Godwin törvényével, miszerint egy "internetes vita terebélyesedésével annak az esélye, hogy valaki a nácikkal, vagy Hitlerrel von valamilyen párhuzamot, közelít az egyhez".

A Tay által használt gépi tanulás lényege, hogy a mesterséges intelligencia megfigyelésekből és tapasztalatokból von le következtetéseket, ezekkel válik egyre finomabbá. Ilyen technológián alapul a Google AlphaGo szoftvere is, aki 4:1-re verte meg a világ legjobb gójátékosát. Az ezen elven tanuló robotokat jellemzően egy speciális szakterületre képzik ki, jelen esetben arra, hogy hatalmas szövegmennyiségből tanulja meg, hogyan kell válaszolni.

A Microsoft nem csak kikapcsolta Tay-t, de elkezdte törölni az offenzív tweeteket is. A SocialHox oldal azonban többet is megőrzött belőle az utókornak.

A cég így kommentálta a döntést: „Az AI chatbotunk egy gépi tanulási projekt. Ugyanannyira közösségi és kulturális kísérlet, mint technikai. Sajnos az elmúlt 24 órában néhány felhasználó célzottan arra használta, hogy elfogadhatatlan válaszokra tanítsa. Ezért Tayt elérhetetlenné tettük, és alkalmazkodunk ehhez.

Tay így egy utolsó tweetben el is köszönt az internet népétől. A Microsoft nem készült fel erre, de az eset tanulságos. Felmerül a kérdés: ha a robotot úgy tanítjuk, hogy az embereket utánozza, milyen példákat választunk neki?